- 綠色版查看

- 綠色版查看

- 綠色版查看

- 綠色版查看

- 綠色版查看

主要功能

Ollama支持從官方模型庫或自定義模型庫拉取預訓練模型,并在本地保存和加載,同時兼容ONNX、PyTorch、TensorFlow等多種流行的模型格式。通過GPU/CPU加速,Ollama提供高效的模型推理,適合本地化應用或需要控制數據隱私的場景。它支持多種接口訪問推理服務,包括命令行(CLI)、HTTP接口,并可通過OpenAI客戶端實現更廣泛的集成。此外,用戶還可以通過靈活的環境變量自定義推理設備(GPU/CPU)、緩存路徑、并發數、日志級別等。

安裝與配置

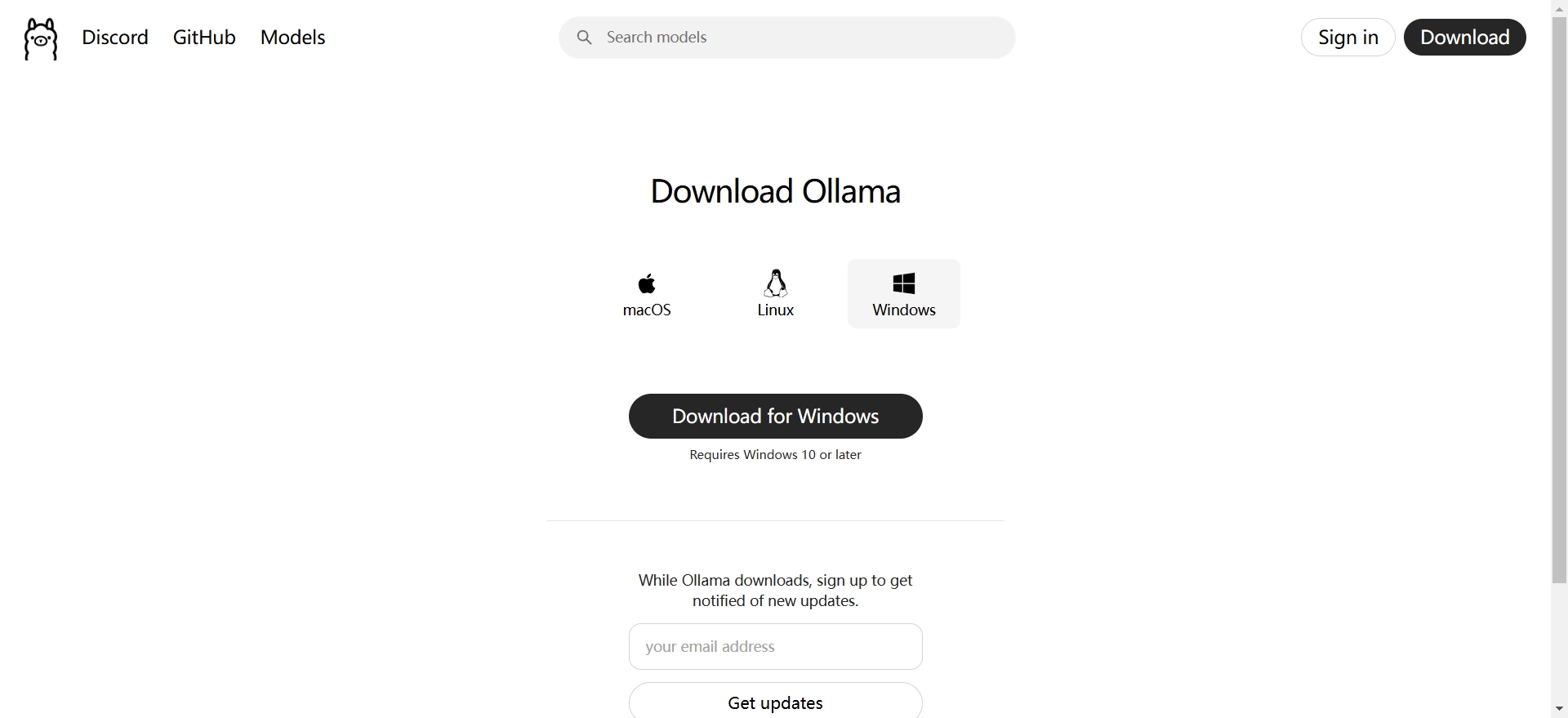

用戶可以從Ollama官網下載桌面軟件,或通過命令行安裝Ollama CLI工具。安裝完成后,用戶可以通過環境變量進行配置,如指定模型存儲路徑、選擇推理使用的設備、設置日志級別等。Ollama還提供了多種命令,方便用戶進行模型管理和推理,如查看幫助信息、查看可用模型、拉取模型、刪除模型、檢查模型狀態等。

應用場景

Ollama適用于多種場景,包括但不限于:

1.數據隱私保護:對于擔心數據發送到云端會產生安全風險的用戶,Ollama可以在本地處理數據,避免數據傳輸到外部服務器帶來的潛在風險。

2.開發和測試:開發人員可以使用Ollama在本地快速搭建語言模型環境,用于開發新的語言相關的應用程序,如智能客服機器人等。

3.個人學習和研究:對于研究自然語言處理的學者或對語言模型感興趣的個人來說,Ollama提供了一個方便的實驗平臺,可以在本地加載不同的模型,對比它們的性能,研究模型的輸出特性等。

優勢特點

1.輕量化設計:Ollama工具體積小巧,安裝簡便,不會占用過多系統資源。

2.多模型支持:除了支持DeepSeek外,Ollama還支持Llama、Qwen等其他流行的大型語言模型。

3.社區支持:Ollama擁有活躍的開發者社區,提供了豐富的文檔和教程,幫助用戶解決遇到的各種問題。

常見問題

模型下載卡在99%或失敗

原因:網絡不穩定、代理設置錯誤、磁盤空間不足。

解決方案:

按 Ctrl+C 取消下載,重新運行 ollama pull <模型名>。

檢查網絡連接,或設置代理(如HTTPS_PROXY環境變量)。

確保磁盤有足夠空間(如模型默認路徑為C盤,可修改為其他盤符)。

模型存儲路徑修改

方法:設置環境變量 OLLAMA_MODELS 為新路徑(如 D:ollamamodels),重啟終端生效。

驗證:通過 ollama list 查看模型是否存儲在新路徑。

模型無響應或崩潰

原因:Modelfile配置錯誤、系統資源不足(內存/顯存)。

解決方案:

檢查Modelfile中的路徑和參數是否正確。

使用輕量模型(如 deepseek:1.5b)或低精度版本(如 q4_K_M)。

通過 ollama run --verbose <模型名> 查看資源消耗,調整并發數(OLLAMA_NUM_PARALLEL)。

ollama更新日志:

1. 優化的腳步從未停止!

2. 更多小驚喜等你來發現~

華軍小編推薦:

ollama功能和官方出品的一樣齊全,界面更加美觀大方,設計更完善,不斷滿足用戶的需求歡迎下載。感興趣的還可以下載今目標、漢王考勤管理系統、愛莫腦圖、WPS Office、快刀客平臺軟件

您的評論需要經過審核才能顯示

有用

有用

有用